Fusión Sensorial No Lineal Basada en Regresión de Soporte Vectorial para la Estimación de Distancia en Robótica Móvil

Nonlinear Sensor Fusion Based on Support Vector Regression for Distance Estimation in Mobile Robotics

Barra lateral del artículo

Términos de la licencia (VER)

Esta obra está bajo una licencia internacional Creative Commons Atribución-NoComercial-SinDerivadas 4.0.

Declaración del copyright

Los autores ceden en exclusiva a la Universidad EIA, con facultad de cesión a terceros, todos los derechos de explotación que deriven de los trabajos que sean aceptados para su publicación en la Revista EIA, así como en cualquier producto derivados de la misma y, en particular, los de reproducción, distribución, comunicación pública (incluida la puesta a disposición interactiva) y transformación (incluidas la adaptación, la modificación y, en su caso, la traducción), para todas las modalidades de explotación (a título enunciativo y no limitativo: en formato papel, electrónico, on-line, soporte informático o audiovisual, así como en cualquier otro formato, incluso con finalidad promocional o publicitaria y/o para la realización de productos derivados), para un ámbito territorial mundial y para toda la duración legal de los derechos prevista en el vigente texto difundido de la Ley de Propiedad Intelectual. Esta cesión la realizarán los autores sin derecho a ningún tipo de remuneración o indemnización.

La autorización conferida a la Revista EIA estará vigente a partir de la fecha en que se incluye en el volumen y número respectivo en el Sistema Open Journal Systems de la Revista EIA, así como en las diferentes bases e índices de datos en que se encuentra indexada la publicación.

Todos los contenidos de la Revista EIA, están publicados bajo la Licencia Creative Commons Atribución-NoComercial-NoDerivativa 4.0 Internacional

Licencia

![]()

Esta obra está bajo una Licencia Creative Commons Atribución-NoComercial-NoDerivativa 4.0 Internacional

Contenido principal del artículo

Resumen

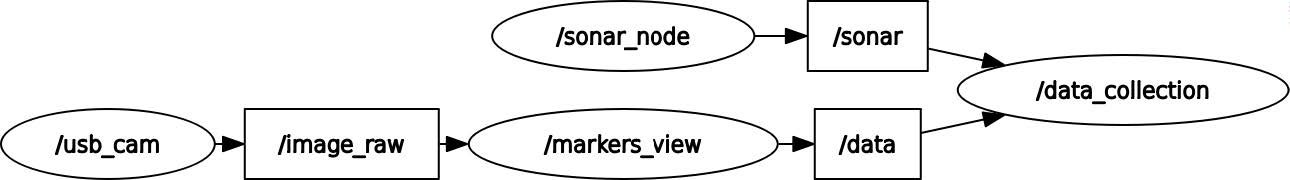

La estimación precisa de distancias es un desafío crítico en robótica móvil, especialmente en entornos dinámicos donde la incertidumbre de los sensores puede afectar la navegación y la evasión de obstáculos. Este artículo propone un método de fusión sensorial no lineal basado en Regresión de Soporte Vectorial (SVR) para mejorar la estimación de distancias, utilizando un sistema de bajo costo compuesto por una cámara Logitech C270 con marcadores fiduciales ArUco, un sensor ultrasónico HC-SR04, un microcontrolador ESP32 y el middleware ROS2. La configuración experimental recopiló datos de 20 a 400 cm en intervalos de 10 cm, incorporando oclusiones controladas para simular condiciones reales. El modelo SVR, optimizado con un núcleo de función de base radial (C=10, gamma=0.5, epsilon=0.5), fusiona datos visuales y acústicos para mejorar la robustez y precisión. Los resultados de las pruebas de validación (30-200 cm) muestran que las estimaciones de distancia fusionadas alcanzan un error absoluto promedio de 1.25 cm en condiciones normales, con un pico de error cuadrático medio de 35.44 cm² a 30 cm, indicando limitaciones en rangos cortos. Bajo oclusión, la fusión reduce los errores de los sensores individuales (por ejemplo, 19.81 cm para el sonar y 35.08 cm para la cámara a 100 cm) a un promedio de 32.49 cm. Las principales contribuciones incluyen un enfoque de fusión económico que incrementa la robustez en condiciones adversas y supera los métodos de un solo sensor. Futuras investigaciones explorarán técnicas de aprendizaje profundo y sensores adicionales para abordar los desafíos en rangos cortos y oclusiones, siguiendo tendencias en integración multimodal de sensores para navegación autónoma.

Descargas

Detalles del artículo

Referencias (VER)

Alatise, M.; Hancke, G. (2020). A review on challenges of autonomous mobile robot and sensor fusion methods. IEEE Access, 8, 39830-39846. https://doi.org/10.1109/ACCESS.2020.2975643

Andronie, M.; Lăzăroiu, G.; Iatagan, M.; Hurloiu, I.; Ștefănescu, R.; Dijmărescu, A.; Dijmărescu, I. (2023). Big data mana-gement algorithms, deep learning-based object detection technologies, and geospatial simulation and sensor fusion tools in the internet of robotic things. ISPRS International Journal of Geo-Information, 12(35). https://doi.org/10.3390/ijgi12020035

Barreto, A.; Gómez, A.; Escobedo, J.; Cuan, E.; Cruz, S. (2022). Sensor data fusion for a mobile robot using neural net-works. Sensors, 22(1), 305. https://doi.org/10.3390/s22010305

Duan, S.; Shi, Q.; Wu, J. (2022). Multimodal sensors and ML-based data fusion for advanced robots. Advanced Intelligent Systems, 4(12), 2200213. https://doi.org/10.1002/aisy.202200213

Fayyad, J.; Jaradat, M.; Gruyer, D.; Najjaran, H. (2020). Deep learning sensor fusion for autonomous vehicle perception and localization: A review. Sensors, 20(15), 4220. https://doi.org/10.3390/s20154220

Hafez, O.; Joerger, M.; Spenko, M. (2024). How safe is particle filtering-based localization for mobile robots? An inte-grity monitoring approach. IEEE Transactions on Robotics, 40, 3372–3387. https://doi.org/10.1109/TRO.2024.3420798

Housein, A. A.; Xingyu, G.; Li, W.; Huang, Y. (2022). Extended Kalman filter sensor fusion in practice for mobile robot localization. International Journal of Advanced Computer Science and Applications, 13(2), 33-38. https://doi.org/10.14569/IJACSA.2022.0130204

Kaczmarek, A.; Rohm, W.; Klingbeil, L.; Tchórzewski, J. (2022). Experimental 2D extended Kalman filter sensor fusion for low-cost GNSS/IMU/Odometers precise positioning system. Measurement, 193, 110963. https://doi.org/10.1016/j.measurement.2022.110963

Krishnamurthi, R.; Kumar, A.; Gopinathan, D.; Nayyar, A.; Qureshi, B. (2020). An overview of IoT sensor data proces-sing, fusion, and analysis techniques. Sensors, 20(21), 6076. https://doi.org/10.3390/s20216076

Kumari, N.; Kulkarni, R.; Ahmed, M.; Kumar, N. (2021). Use of Kalman filter and its variants in state estimation: A re-view. En: Artificial Intelligence for a Sustainable Industry 4.0 (pp. 213-230). https://doi.org/10.1007/978-3-030-77070-9_13

Li, C.; Fahmy, A.; Sienz, J. (2019). An augmented reality based human-robot interaction interface using Kalman filter sensor fusion. Sensors, 19(20), 4586. https://doi.org/10.3390/s19204586

Li, Y.; He, L.; Zhang, X.; Zhu, L.; Zhang, H.; Guan, Y. (2019). Multi-sensor fusion localization of indoor mobile robot. En: IEEE International Conference on Real-time Computing and Robotics (RCAR) (pp. 481-486). https://doi.org/10.1109/RCAR47638.2019.9044006

Lv, M.; Wei, H.; Fu, X.; Wang, W.; Zhou, D. (2022). A loosely coupled extended Kalman filter algorithm for agricultural scene-based multi-sensor fusion. Frontiers in Plant Science, 13, 849260. https://doi.org/10.3389/fpls.2022.849260

Moreira, A.; Costa, P.; Lima, J. (2020). New approach for beacons based mobile robot localization using Kalman filters. Procedia Manufacturing, 51, 512-519. https://doi.org/10.1016/j.promfg.2020.10.072

Mráz, E.; Trizuljak, A.; Rajchl, M.; Sedláček, M.; Štec, F.; Stanko, J.; Rodina, J. (2024). Multi-sensor fusion for robust in-door localization of industrial UAVs using particle filter. Journal of Electrical Engineering, 75(4), 304-316. https://doi.org/10.2478/jee-2024-0037

Oliveira, R.; Ott, L.; Guizilini, V.; Ramos, F. (2020). Bayesian optimisation for safe navigation under localisation uncer-tainty. En: Robotics Research: The 18th International Symposium ISRR (pp. 489-504). Springer International Publis-hing. https://doi.org/10.48550/arXiv.1709.02169

Ortega, J.; Gutiérrez, O.; Aguirre, J. (2022). Simulación del control de un robot móvil tipo Rover basado en fusión de sensores mediante filtro de partículas. Pädi Boletín Científico de Ciencias Básicas e Ingenierías del ICBI, 10, 100-106. https://doi.org/10.29057/icbi.v10iEspecial6.9366

Sander, J.; Beyerer, J. (2013). Bayesian fusion: Modeling and application. En: 2013 Workshop on Sensor Data Fusion: Trends, Solutions, Applications (SDF) (pp. 1-6). IEEE. https://doi.org/10.1109/SDF.2013.6698254

Shaukat, N.; Ali, A.; Javed, M.; Moinuddin, M.; Otero, P. (2021). Multi-sensor fusion for underwater vehicle localization by augmentation of RBF neural network and error-state Kalman filter. Sensors, 21(4), 1149. https://doi.org/10.3390/s21041149

Shen, Y.; Liu, H.; Liu, X.; Zhou, W.; Zhou, C.; Chen, Y. (2024). Localization through particle filter powered neural network estimated monocular camera poses. arXiv preprint, arXiv:2404.17685. https://doi.org/10.48550/arXiv.2404.17685

Tang, Q.; Liang, J.; Zhu, F. (2023). A comparative review on multi-modal sensors fusion based on deep learning. Signal Processing, 213, 109165. https://doi.org/10.1016/j.sigpro.2023.109165

Urrea, C.; Agramonte, R. (2021). Kalman filter: Historical overview and review of its use in robotics 60 years after its creation. Journal of Sensors, 2021(1), 9674015. https://doi.org/10.1109/MSP.2025.3569395

Yeong, D.; Velasco, G.; Barry, J.; Walsh, J. (2021). Sensor and sensor fusion technology in autonomous vehicles: A re-view. Sensors, 21(6), 2140. https://doi.org/10.3390/s21062140

PDF

PDF

FLIP

FLIP